这个n8n模板展示了如何将GitHub的免费模型连接到您现有的n8n AI工作流中。

虽然可以使用HTTP节点访问GitHub模型,但此模板的目标是将其与现有的n8n LLM节点一起使用 – 避免了重构的麻烦!

请注意,GitHub声明他们的模型API不适用于生产用途!如果您需要更高的速率限制,您需要使用付费服务。

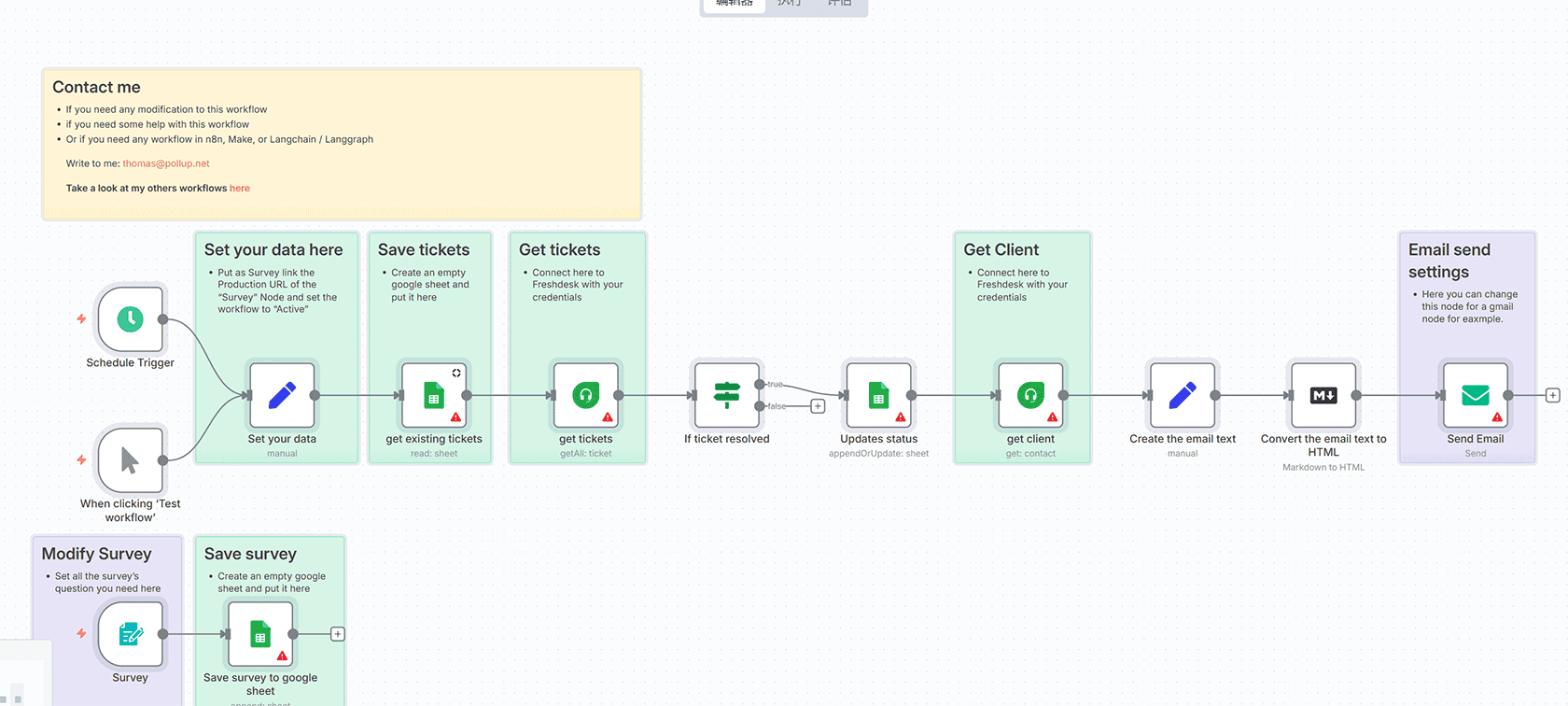

工作原理

该方法围绕GitHub模型API构建了一个自定义的OpenAI兼容API – 全部在n8n中完成!

首先,我们将一个OpenAI子节点附加到我们的LLM节点,并配置一个新的OpenAI凭据。

在这个新的OpenAI凭据中,我们将”Base URL”更改为指向我们在此模板中准备的n8n webhook。

接下来,我们创建2个webhook,LLM节点现在将尝试连接:”models”和”chat completion”。

“models” webhook简单地调用GitHub模型的”list all models”端点,并将响应重新映射以与我们的LLM节点兼容。

“Chat Completion” webhook对GitHub的Chat Completion端点执行类似的任务。

使用方法

连接后,只需打开聊天并提问!

任何连接到此自定义LLM子节点的LLM或AI代理节点都将向GitHub模型API发送请求。允许您免费试用一系列SOTA模型。

要求

GitHub帐户和访问模型的凭据。如果您之前使用过GitHub节点,可以为此模板重用此凭据。

自定义此工作流

此模板只是一个示例。将自定义OpenAI凭据用于您其他工作流以测试GitHub模型。

参考

https://docs.github.com/en/github-models/prototyping-with-ai-models

https://docs.github.com/en/github-models

评论(0)