这个n8n工作流允许您通过用户友好的聊天界面无缝地与自托管的大型语言模型(LLMs)进行交互。通过连接到Ollama(一个用于管理本地LLMs的强大工具),您可以直接在n8n中发送提示并接收AI生成的响应。

使用场景

私有AI交互

适用于数据隐私和保密性很重要的场景。

经济高效的LLM使用

通过在自己的硬件上运行模型来避免持续的云API成本。

实验与学习

在本地受控环境中探索和实验不同LLMs的好方法。

原型设计与开发

在不依赖外部服务的情况下构建和测试AI驱动的应用程序。

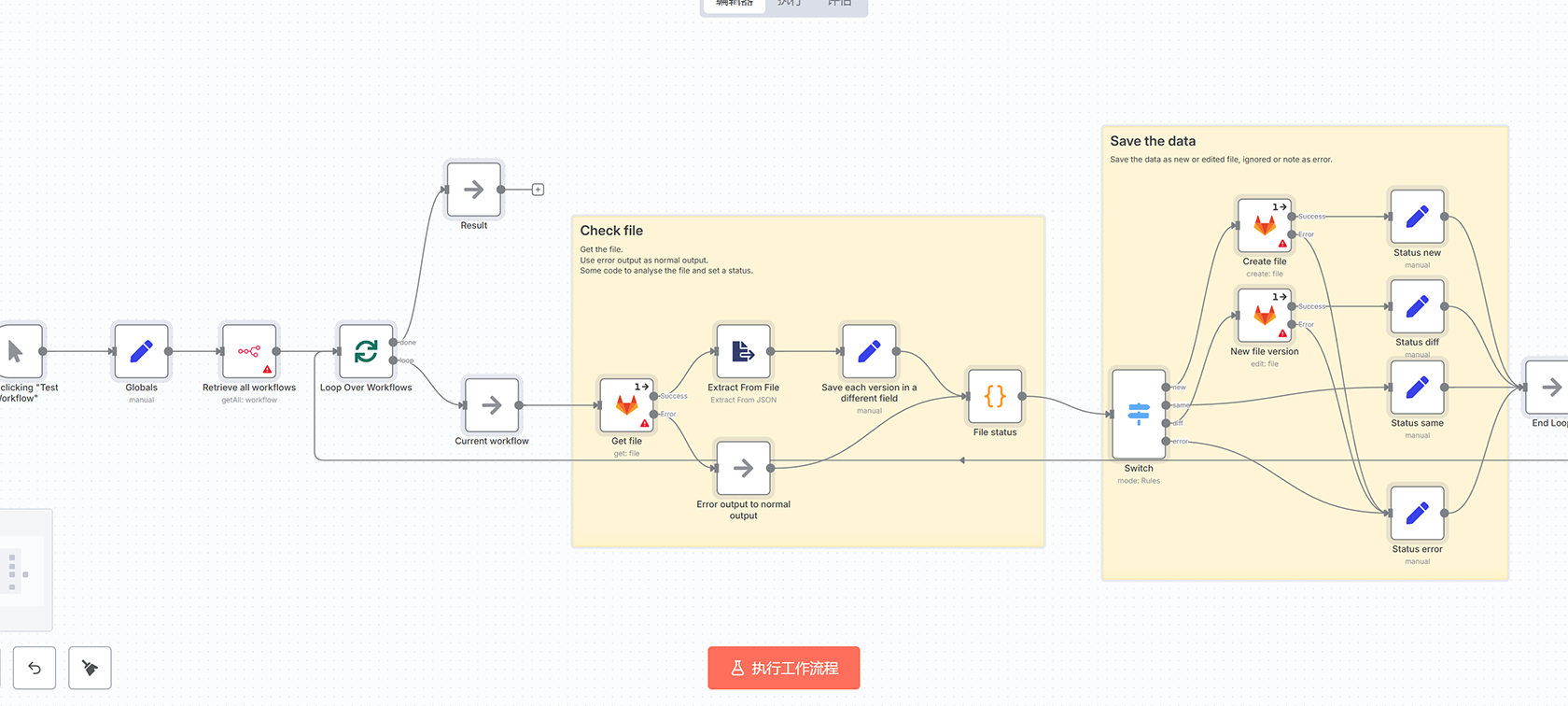

工作原理

当收到聊天消息时:从聊天界面捕获用户的输入。

Chat LLM Chain:将输入发送到Ollama服务器并接收AI生成的响应。

将LLM的响应传递回聊天界面。

设置步骤

在执行此工作流之前,请确保Ollama已安装并在您的机器上运行。

如果Ollama地址与默认值不同,请编辑该地址。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)