这个工作流允许您在投入生产前轻松评估和比较两种语言模型(LLM)的输出结果。

在聊天界面中,两个模型的输出会并排显示。它们的响应也会被记录到Google Sheets中,可以通过手动方式或使用更高级的模型进行自动评估。

## 使用场景

您正在开发一个AI代理,由于LLM具有非确定性特性,您希望确定哪种模型最适合您的特定用例。这个模板旨在帮助您有效地进行比较。

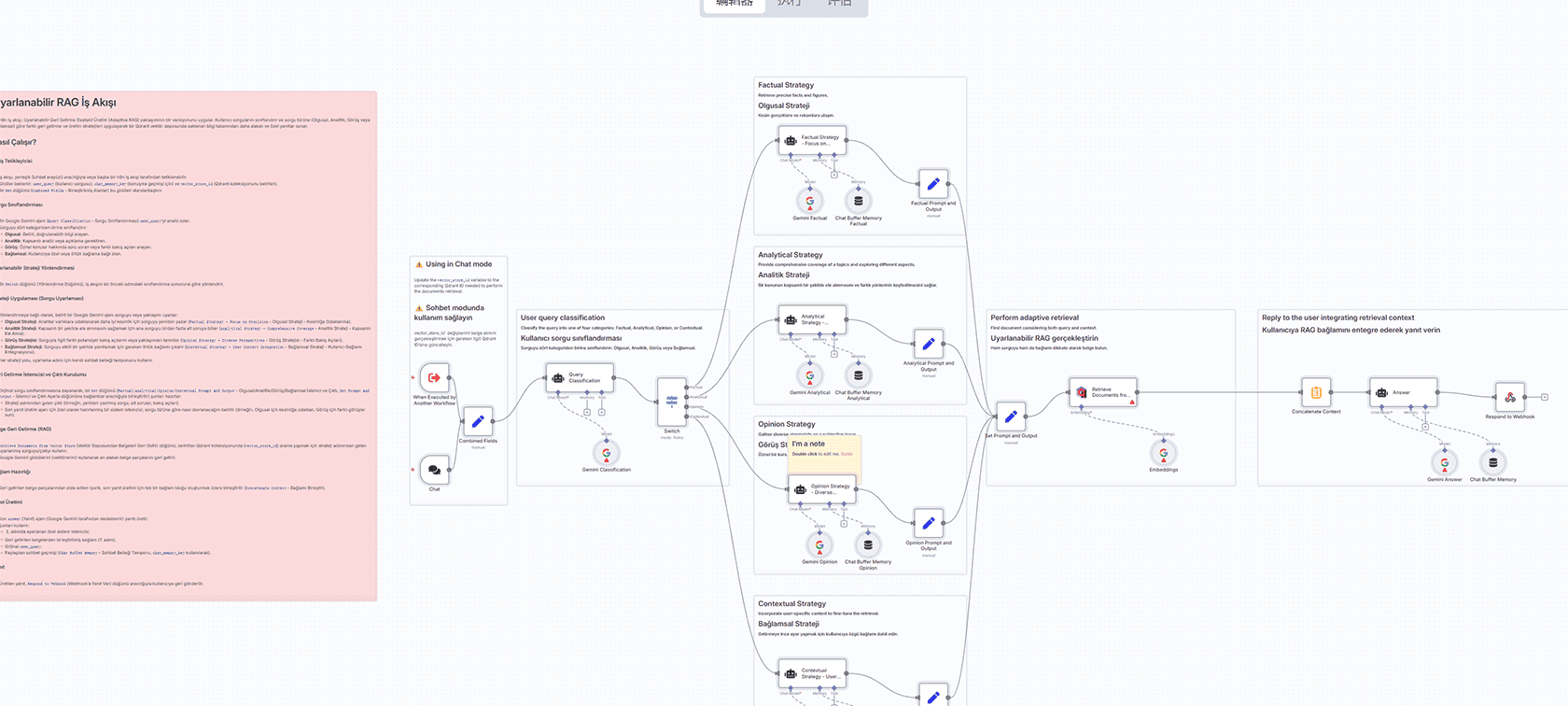

## 工作原理

– 用户向聊天界面发送消息

– 输入被复制并发送到两个不同的LLM

– 每个模型使用自己的内存上下文独立处理相同的提示

– 它们的答案,连同用户输入和先前上下文,被记录到Google Sheets

– 您可以手动(或稍后自动化)查看、比较和评估模型输出

– 在聊天中,两个响应也会依次显示以便直接比较

## 如何使用

– 复制这个Google Sheets模板(文件 > 创建副本)

– 在AI Agent节点中设置您的系统提示和工具以适应您的用例

– 开始聊天!每条消息都会触发两个模型并将它们的响应记录到电子表格

*注意:此版本设置为两个模型。如果您想比较更多模型,需要扩展工作流逻辑并更新表格。*

## 关于模型

您可以使用OpenRouter或Vertex AI来测试不同提供商之间的模型。

如果您使用特定提供商的节点,如OpenAI,您可以比较该提供商的不同模型(例如gpt-4.1 vs gpt-4.1-mini)。

## Google Sheets中的评估

这非常适合团队使用,允许非技术利益相关者(不仅仅是数据科学家)根据实际需求评估响应。

高级用户可以使用更强大的模型(如OpenAI的o3)自动化此评估,但请注意这会增加令牌使用量和成本。

## 令牌考虑因素

由于每个输入都由两个不同的模型处理,工作流总体上会消耗更多令牌。

请密切关注使用情况,特别是在处理较长的提示或运行多个评估时,因为这可能会影响成本。

评论(0)