这个n8n模板演示了如何计算评估指标”正确性”,该指标用于比较和分类AI代理的响应与一组基准事实。

## 工作原理

这个评估最适合用于允许AI代理响应更加详细和对话式的场景。在我们的评分方法中,我们将AI代理的响应分为3个类别:

– **真阳性(TP)**:在答案和基准事实中都存在的陈述

– **假阳性(FP)**:在答案中存在但基准事实不支持的陈述

– **假阴性(FN)**:在基准事实中存在但答案中缺失的陈述

我们还计算AI代理响应与所有基准事实之间的平均相似度分数。分类结果和相似度分数随后进行平均计算,得出最终分数。

高分数表示AI代理准确,而低分数可能表明AI代理的训练数据不正确或提供的答案不够全面。

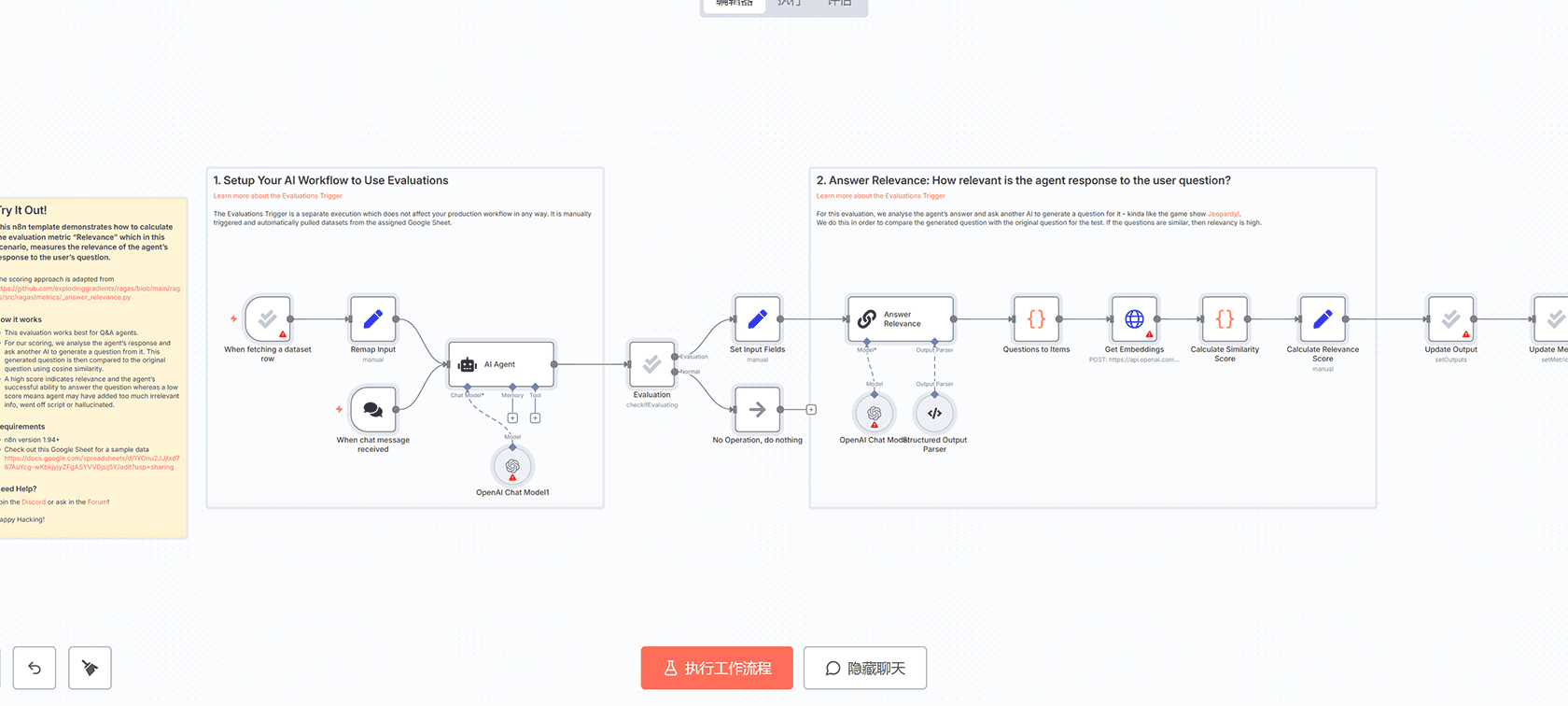

## 技术实现

该工作流集成了多个n8n节点:

– **AI代理节点**:处理用户输入并生成响应

– **正确性分类器**:使用OpenAI模型对响应进行分类

– **嵌入计算**:通过OpenAI API计算文本嵌入向量

– **相似度评分**:计算余弦相似度

– **F1分数计算**:基于TP、FP、FN计算F1分数

– **最终评分**:结合F1分数和相似度分数得出综合评分

## 数据源

工作流从Google Sheets获取测试数据集,包含问题、AI代理响应和基准事实。评分方法基于开源评估项目RAGAS,确保评估的科学性和可靠性。

## 应用场景

– AI聊天机器人性能评估

– 训练数据质量验证

– 对话系统准确性测试

– 知识库问答系统优化

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)