## 工作流概述

这个n8n工作流实现了一个智能的AI模型评估系统,使用大型语言模型(LLM)作为法官来评估其他AI模型的输出质量。工作流通过Google Sheets管理测试用例,并行执行评估,并将结果记录到输出表格中。

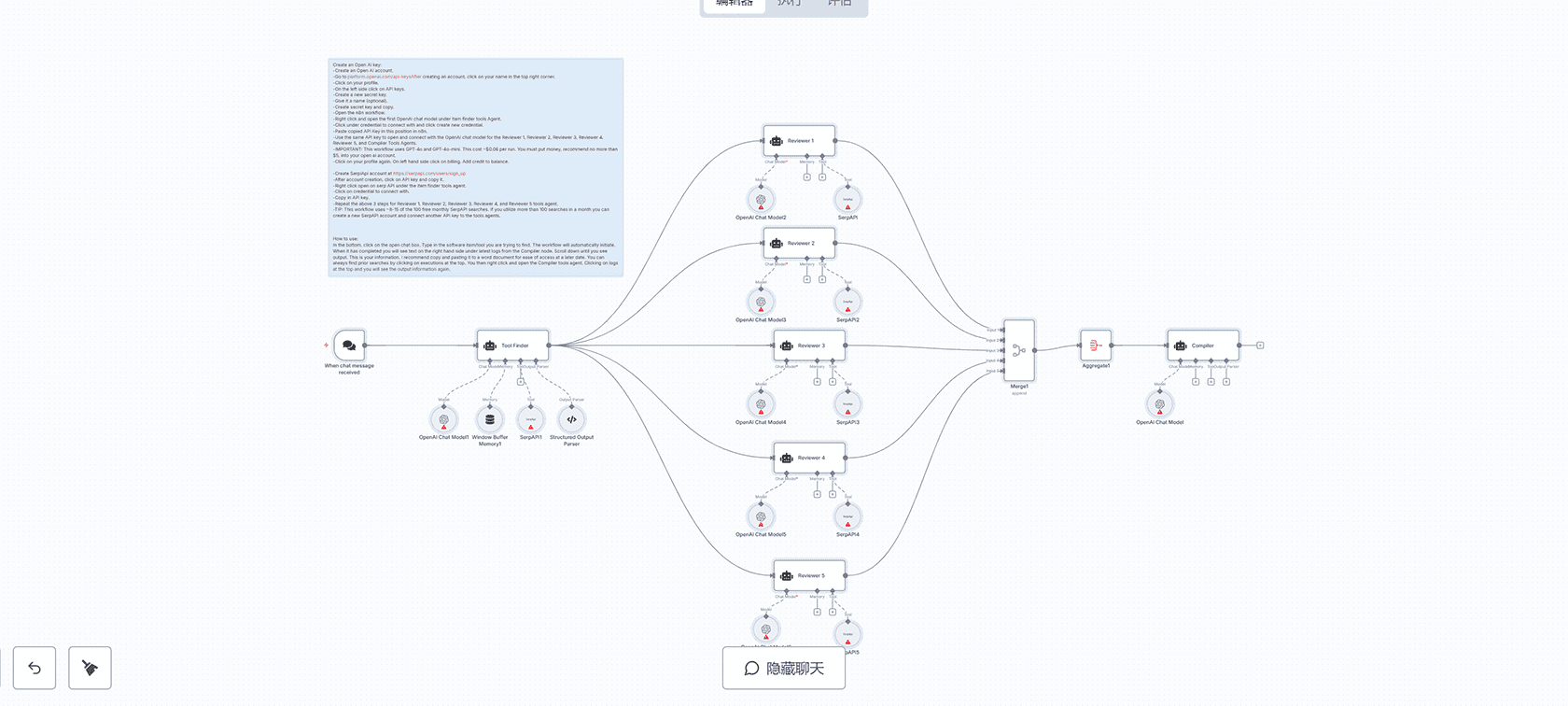

## 工作原理

### 1. 获取测试用例

工作流从Google Sheets中加载测试用例列表,这些测试用例包含之前从LLM存储的结果。测试表格包含以下列:

– ID:每行的唯一标识符

– Test No.:给LLM的测试编号

– AI Platform:被测试的LLM平台

– Input:给LLM的输入提示

– Output:LLM的响应

– Reference Answer:问题的”黄金标准”答案

### 2. 执行子工作流

该节点立即运行(批量处理请求),但在移动到下一步之前等待结果。

### 3. 评估LLM输出

我们的提示词会评估LLM的输入/输出,并根据输出与参考答案的匹配程度来决定LLM是否通过测试。

我们还要求法官提供决策原因,以便后续改进评估标准。

我们在此使用OpenRouter,这样可以轻松调整我们想要使用的LLM。

输出解析器确保输出为JSON格式,使数据在下一步易于解析。

### 4. 更新结果

我们在输出表格中创建新行,包含原始数据以及法官的决策/推理。

## 设置步骤

1. 添加Google Sheets和OpenRouter的凭据(或用您喜欢的聊天模型替换OpenRouter节点)

2. 复制示例表格以填充您自己的测试数据

3. 点击Manual Trigger节点旁边的”Execute Workflow”按钮运行工作流

## 评估标准

法官根据以下标准评估AI助手的输出:

### 通过标准

1. **事实准确性**:输出必须准确反映参考答案中的信息

2. **查询相关性**:输出必须直接回答任务,如参考答案所述

3. **完整性**:如果输出包含不矛盾或歪曲参考答案的额外信息,这是可接受的

### 关键规则

– 如果输出在任何一个要求上与参考答案存在实质性差异,则评为失败

– 轻微的措辞或风格差异是可接受的,只要实质含义相同

## 技术特点

– 使用并行处理提高评估效率

– 结构化JSON输出便于数据解析

– 灵活的LLM选择机制

– 完整的错误处理和重试机制

评论(0)